A Apple revelou recentemente que vai implementar alguns mecanismos nos seus sistemas operativos para combater a propagação da pornografia infantil. Contudo, o anúncio gerou alguma polémica, apesar da Apple já ter o sistema implementado no iCloud. Ora foi exatamente neste serviço que foram detetadas mais de 2 mil imagens e vídeos de exploração sexual de crianças.

O Departamento de Justiça dos EUA acusou um médico de São Francisco da posse deste material ilícito.

Pornografia infantil encontrada no iCloud

No meio da polémica gerada em torno do sistema de deteção CSAM da Apple, um médico de São Francisco foi acusado de posse de pornografia infantil na sua conta do Apple iCloud, de acordo com autoridades federais.

O Departamento de Justiça dos EUA anunciou na quinta-feira que Andrew Mollick, de 58 anos, tinha pelo menos 2.000 imagens e vídeos de exploração sexual de crianças armazenados na sua conta do iCloud.

Mollick é um especialista em oncologia afiliado a vários médicos da Bay Area. Além disso, é também professor da UCSF School of Medicine.

Segundo a investigação, o médico carregou uma das imagens na aplicação da rede social Kik, conforme a queixa federal recentemente aberta.

Apple não quer material ilícito no seu ecossistema

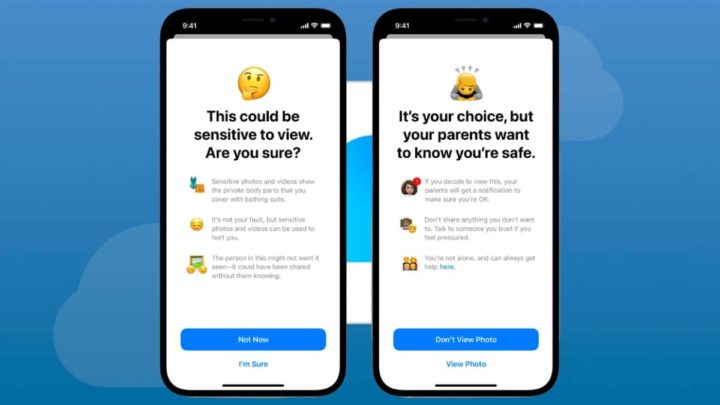

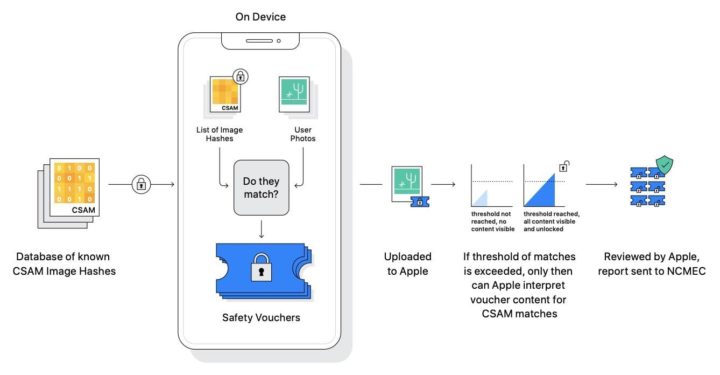

A Apple anunciou recentemente planos para introduzir um sistema projetado para detetar material de abuso sexual infantil (CSAM) no iCloud e fornecer um relatório ao Centro Nacional para Crianças Desaparecidas e Exploradas (NCMEC).

O sistema, que conta com técnicas criptográficas para garantir a privacidade do utilizador, tem gerado polémica entre as comunidades de direitos digitais e cibersegurança.

O sistema não verifica as imagens reais da conta iCloud de um utilizador. Em vez disso, ele baseia-se na correspondência de hashes de imagens armazenadas no iCloud com hashes CSAM fornecidos por pelo menos duas organizações de segurança infantil.

Também há um limite de pelo menos 30 peças de CSAM para ajudar a mitigar falsos positivos.

Sistema CSAM no iPhone, iPad e Mac vai avançar

Documentos revelados durante o julgamento Epic Games vs Apple indicavam que o chefe anti-fraude da Apple Eric Friedman pensava que os serviços da empresa de Cupertino eram a "maior plataforma de distribuição" da CSAM. Friedman atribuiu este facto à forte posição da Apple sobre a privacidade dos utilizadores.

Apesar da reação, a Apple avança com os seus planos para lançar o sistema de deteção CSAM. A gigante de Cupertino afirma que a plataforma ainda preservará a privacidade dos utilizadoresque não possuem coleções de CSAM nas suas contas do iCloud.

Fonte: Pplware.