Estamos a poucos dias do WWDC 2025 e a Apple levantou oficialmente o véu do iOS 19. Hoje, empresa de Tim Cook revelou as novas funcionalidades de acessibilidade deste ano para iPhone, iPad, Mac, Apple Watch e Apple Vision Pro. As funcionalidades surgem numa altura em que a Apple celebra 40 anos de inovação em matéria de acessibilidade, tendo a empresa inaugurado o seu gabinete para a deficiência em 1985.

Na Apple, a acessibilidade faz parte do nosso ADN. Tornar a tecnologia acessível a todos é uma prioridade para todos nós, e estamos orgulhosos das inovações que partilhamos este ano. Isso inclui ferramentas que ajudam as pessoas a aceder a informações cruciais, a explorar o mundo à sua volta e a fazer o que mais gostam.

Afirmou o CEO da Apple, Tim Cook.

Aí está uma boa parte do iOS 19 e macOS 16

Estas funcionalidades estão destinadas às próximas atualizações do iOS 19 e do macOS 16 da Apple, que serão anunciadas na WWDC no próximo mês. A Apple, no entanto, não se refere especificamente ao “iOS 19” prematuramente.

As novas funcionalidades de acessibilidade deste ano incluem etiquetas nutricionais de acessibilidade na App Store, uma nova aplicação Lupa para Mac, grandes atualizações da funcionalidade Voz Pessoal da Apple e muito mais.

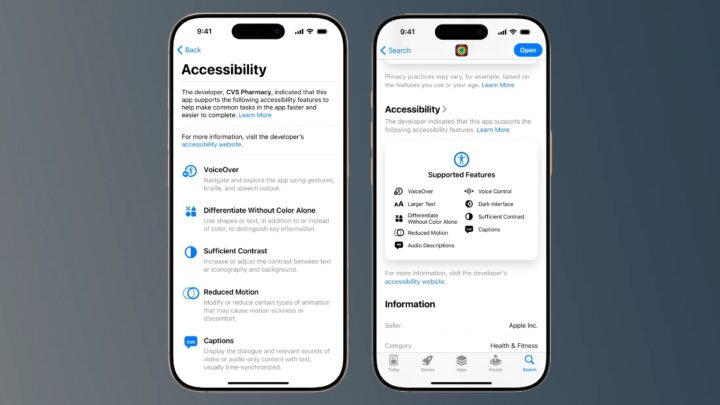

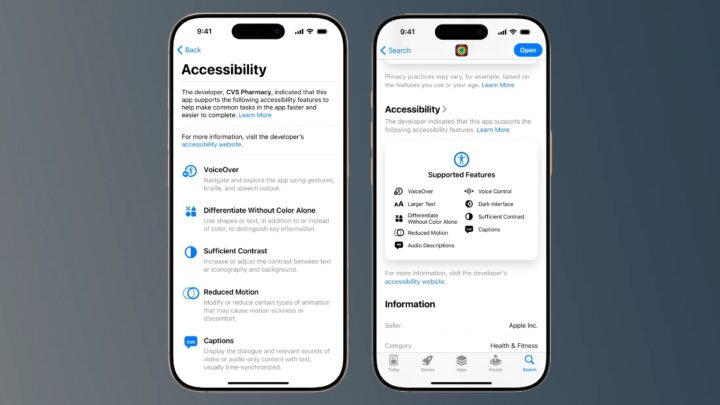

Etiquetas nutricionais de acessibilidade na App Store

O anúncio da Apple das novas funcionalidades de acessibilidade do iOS 19 é encabeçado por uma atualização para a App Store. Ainda este ano, a Apple irá adicionar uma nova secção de Etiquetas nutricionais de acessibilidade às listagens da App Store.

Trata-se de uma funcionalidade semelhante às etiquetas nutricionais de privacidade que a Apple lançou há vários anos e que permite aos utilizadores ver facilmente as práticas de privacidade de cada aplicação.

As novas etiquetas nutricionais de acessibilidade mostrarão aos utilizadores quais as funcionalidades de acessibilidade suportadas por uma aplicação antes de a descarregarem. Isto inclui VoiceOver, Controlo por voz, Texto maior, Contraste suficiente, Movimento reduzido, legendas e muito mais.

A Apple afirma que irá partilhar mais detalhes sobre as etiquetas nutricionais de acessibilidade para programadores na WWDC25.

Lupa para Mac

Em conjunto com o iOS 19, a Apple traz a sua aplicação Lupa para o Mac pela primeira vez este ano com o macOS 16. A app Lupa está disponível no iPhone e iPad desde 2016 como forma de dar aos utilizadores cegos ou com baixa visão a capacidade de ampliar, ler texto e detetar objetos à sua volta.

A nova aplicação Lupa para Mac funciona com um iPhone ligado através da câmara de continuidade ou de uma câmara USB. Uma vez ligado, os utilizadores podem fazer zoom no que os rodeia com um feed de vídeo na aplicação Magnifier no Mac.

Também podem manipular o vídeo para ajustar elementos como a perspetiva, o brilho, o contraste, as cores e muito mais para facilitar a leitura. A aplicação Lupa pode até reconhecer texto.

Por exemplo, a aplicação Lupa no Mac pode ser utilizada para aumentar o zoom num quadro branco numa reunião ou palestra.

Em seguida, a aplicação pode reconhecer inteligentemente o texto escrito à mão nesse quadro branco e torná-lo mais legível e fácil de ler diretamente no Mac do utilizador.

Leitor de acessibilidade

Segundo a Apple, a Leitura de Acessibilidade é um novo modo de leitura para todo o sistema, concebido para facilitar a leitura de texto a utilizadores com uma grande variedade de deficiências, como dislexia ou baixa visão.

Disponível no iPhone, iPad, Mac e Apple Vision Pro, a Leitura de acessibilidade oferece aos utilizadores novas formas de personalizar o texto e de se concentrarem no conteúdo que pretendem ler, com opções alargadas de tipo de letra, cor e espaçamento, bem como suporte para Conteúdo falado.

A Leitura de acessibilidade pode ser iniciada a partir de qualquer aplicação e está integrada na aplicação Lupa para iOS, iPadOS e macOS, para que os utilizadores possam interagir com o texto no mundo real, como em livros ou em menus de restaurantes.

Acesso Braille

A Apple afirma que a sua nova experiência Braille Access pode transformar o dispositivo Apple de um utilizador “num bloco de notas em braille com todas as funcionalidades e profundamente integrado no ecossistema Apple”.

Com um lançador de aplicações integrado, os utilizadores podem abrir facilmente qualquer aplicação escrevendo com o Braille Screen Input ou com um dispositivo braille ligado. Com o Braille Access, os utilizadores podem tomar notas rapidamente em formato braille e efetuar cálculos utilizando o Nemeth Braille, um código braille frequentemente utilizado nas salas de aula de matemática e ciências.

Explica a Apple.

Além disso, a Apple afirma que os utilizadores podem abrir ficheiros Braille Ready Format (BRF) diretamente a partir do Braille Access. Isto irá desbloquear uma “vasta gama de livros e ficheiros anteriormente criados num dispositivo de anotações em braille”.

Esta funcionalidade também está associada à poderosa funcionalidade Legendas em direto da Apple, que permite aos utilizadores transcrever conversas em tempo real em ecrãs braille.

Legendas em direto no Apple Watch

Por falar em legendas em direto, o watchOS 12, que será lançado no final deste ano, trará pela primeira vez os controlos do Áudio em direto (Live Listen) para o Apple Watch. Para relembrar, o Áudio em direto chegou pela primeira vez ao iPhone com o iOS 12 em 2018.

A funcionalidade utiliza o microfone de um iPhone para transmitir conteúdo diretamente para AirPods e aparelhos auditivos Made for iPhone, para que seja mais fácil para um utilizador ouvir.

Com o watchOS 12 deste ano, os controlos do Áudio em direto passam a estar disponíveis no Apple Watch, incluindo a capacidade de iniciar ou parar remotamente sessões do Áudio em direto, voltar atrás numa sessão para apanhar algo que possa ter sido perdido e muito mais.

Também há suporte para legendas ao vivo em tempo real, permitindo que os utilizadores acompanhem a conversa através de transcrições ao vivo diretamente no Apple Watch.

Atualizações de voz pessoais

A Apple estreou a sua revolucionária funcionalidade de Voz Pessoal como parte do iOS 17 em 2023. A funcionalidade é uma forma de as pessoas criarem e guardarem uma voz que se pareça com elas.

A empresa de Cupertino afirma que foi concebida para pessoas em risco de perder a capacidade de falar, como as que foram recentemente diagnosticadas com ELA. A funcionalidade está ligada ao Fala em tempo real (Live Speech), que permite aos utilizadores escreverem o que pretendem dizer e ouvir a sua voz.

O processo de configuração da versão inicial do Personal Voice exigia que os utilizadores dissessem 150 frases diferentes para treinar o modelo de aprendizagem automática da Apple. A voz era então processada durante a noite.

No entanto, com o iOS 19 deste ano, a Apple reformulou completamente o processo de configuração. Agora, os utilizadores só precisam de gravar 10 frases diferentes, e estas serão processadas em menos de um minuto, em vez de várias horas durante a noite. O resultado final é uma voz “mais suave” e “mais natural”, de acordo com a Apple.

Atualizações do Vision Pro

Segundo a Apple, para os utilizadores cegos ou com baixa visão, o visionOS vai expandir as funcionalidades de acessibilidade visual utilizando o sistema de câmara avançado do Apple Vision Pro.

Com as poderosas atualizações do Zoom, os utilizadores podem ampliar tudo o que veem, incluindo o que os rodeia, utilizando a câmara principal. Para os utilizadores do VoiceOver, o Reconhecimento em tempo real (Live Recognition) no visionOS utiliza a aprendizagem automática no dispositivo para descrever o ambiente, encontrar objetos, ler documentos e muito mais.

Para os programadores de acessibilidade, uma nova API permitirá que as aplicações aprovadas acedam à câmara principal para fornecer assistência em direto, de pessoa para pessoa, para interpretação visual em aplicações como a Be My Eyes, dando aos utilizadores mais formas de compreender o que os rodeia sem usar as mãos.

Mais funcionalidades de acessibilidade este ano

Estas funcionalidades são apenas a ponta do icebergue. A Apple tem uma longa lista de outras novas capacidades a chegar às suas plataformas ainda este ano, incluindo atualizações para Seguimento do olhar (Eye Tracking), Sons de Fundo, Reconhecimento de Som e muito mais.

- Os Sons de Fundo são mais fáceis de personalizar com novas definições de equalização, a opção de parar automaticamente após um período de tempo e novas ações para automatizações nos Atalhos. Os Sons de fundo podem ajudar a minimizar as distrações para aumentar a sensação de concentração e relaxamento, o que alguns utilizadores consideram poder ajudar com os sintomas de zumbido.

- Para os utilizadores que correm o risco de perder a capacidade de falar, a Voz Pessoal está mais rápida, mais fácil e mais poderosa do que nunca, tirando partido dos avanços na aprendizagem automática e na inteligência artificial no dispositivo para criar uma voz mais suave e natural em menos de um minuto, utilizando apenas 10 frases gravadas.

- A opção Indicação de movimento do veículo, que podem ajudar a reduzir o enjoo quando se anda num veículo em movimento, chegam ao Mac, juntamente com novas formas de personalizar os pontos animados no ecrã do iPhone, iPad e Mac.

- Com o Seguimento dos movimentos da cabeça, os utilizadores poderão controlar mais facilmente o iPhone e o iPad com movimentos da cabeça, à semelhança do Movimento dos olhos.

- Para utilizadores com graves problemas de mobilidade, o iOS, iPadOS e visionOS irão adicionar um novo protocolo para suportar o Controlo por interrutor para Interfaces cérebro-computador (BCIs), uma tecnologia emergente que permite aos utilizadores controlar o dispositivo sem movimento físico. O Assistive Access adiciona uma nova aplicação Apple TV personalizada com um leitor multimédia simplificado. Os programadores também terão apoio na criação de experiências personalizadas para utilizadores com deficiências intelectuais e de desenvolvimento utilizando a API Assistive Access.

- A Música Háptica no iPhone torna-se mais personalizável com a opção de experimentar o haptics para uma música inteira ou apenas para as vozes, bem como a opção de ajustar a intensidade geral dos toques, texturas e vibrações.

- O Reconhecimento de sons adiciona o Reconhecimento de nomes, uma nova forma de os utilizadores surdos ou com dificuldades auditivas saberem quando o seu nome está a ser chamado.

- O Controlo por voz introduz um novo modo de programação no Xcode para programadores de software com mobilidade reduzida. O Controlo por voz também adiciona a sincronização de vocabulário entre dispositivos e expandirá o suporte de idiomas para incluir coreano, árabe (Arábia Saudita), turco, italiano, espanhol (América Latina), chinês mandarim (Taiwan), inglês (Singapura) e russo. As Legendas em direto passam a incluir inglês (Índia, Austrália, Reino Unido, Singapura), chinês mandarim (China continental), cantonês (China continental, Hong Kong), espanhol (América Latina, Espanha), francês (França, Canadá), japonês, alemão (Alemanha) e coreano.

- As actualizações do CarPlay incluem suporte para texto de grandes dimensões. Com as actualizações do Reconhecimento de Som no CarPlay, os condutores ou passageiros surdos ou com dificuldades auditivas podem agora ser notificados do som de um bebé a chorar, para além dos sons exteriores ao carro, como buzinas e sirenes.

- Partilhar definições de acessibilidade é uma nova forma de os utilizadores partilharem rápida e temporariamente as suas definições de acessibilidade com outro iPhone ou iPad. Isto é ótimo para pedir emprestado o dispositivo de um amigo ou utilizar um quiosque público num ambiente como um café.

Portanto, estas são apenas algumas das muitas funcionalidades que irão equipar o iOS 19 e o macOS 16.

Pode encontrar o resumo completo das novas funcionalidades de acessibilidade da Apple para este ano no seu sítio Web.

Fonte: Pplware.