O iOS 17 já mexe, será apresentado dentro de algumas semanas e a Apple começou a levantar o véu das novidades para o iPhone. Assim, num comunicado, a empresa de Cupertino apresentou um conjunto de novas funcionalidades concebidas para acessibilidade cognitiva, visual, auditiva e de mobilidade.

Acessibilidade para pessoas que perderam a faculdade de falar

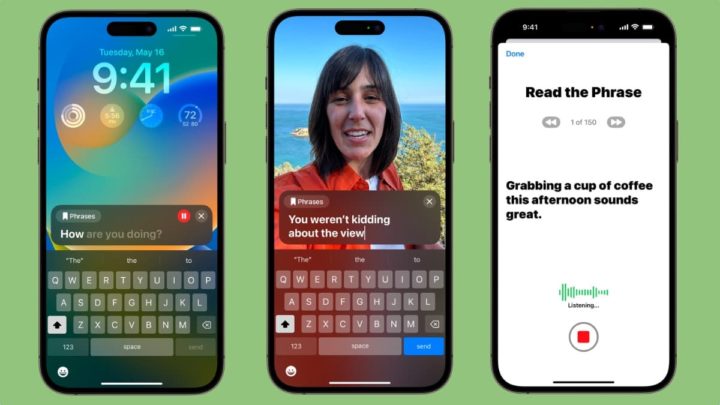

Do que foi já anunciado, as novidades incluem um novo recurso de voz pessoal para pessoas que podem perder a sua capacidade de falar, permitindo-lhes criar "uma voz sintetizada que soa como eles" para conversar com amigos ou familiares.

De acordo com a Apple, os utilizadores podem criar uma Voz Pessoal (Personal Voice) lendo um conjunto de instruções de texto em voz alta, num total de 15 minutos de áudio no iPhone ou iPad. Uma vez que a funcionalidade se integra com o Live Speech, os utilizadores podem escrever o que querem dizer e fazer com que a sua Voz Pessoal o leia para quem quiserem falar.

A Apple afirma que a funcionalidade utiliza "a aprendizagem automática no dispositivo para manter a informação dos utilizadores privada e segura".

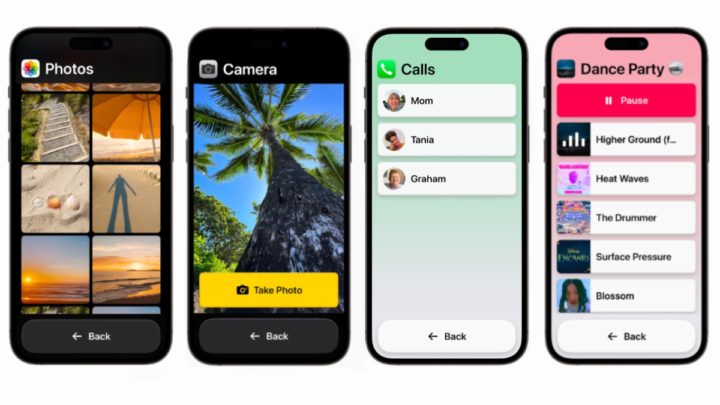

Além disso, a Apple está a introduzir versões simplificadas das suas principais aplicações como parte de uma funcionalidade chamada Assistive Access, destinada a apoiar os utilizadores com deficiências cognitivas. A funcionalidade foi concebida para "refinar aplicações e experiências até às suas funcionalidades essenciais, de forma a aliviar a carga cognitiva".

Isto inclui uma versão combinada do Telefone e do FaceTime, bem como versões modificadas das aplicações Mensagens, Câmara, Fotografias e Música que incluem botões de alto contraste, etiquetas de texto grandes e ferramentas de acessibilidade adicionais.

Mais recursos que virão no iOS 17

Conforme foi detetado, numa versão beta do iOS 16.2, a Apple começou a trabalhar num "modo de acessibilidade personalizado". Contudo, este recurso ainda não foi lançado. A empresa referiu que estes e outros recursos chegarão "ainda este ano", o que sugere que eles podem fazer parte do iOS 17.

Há também um novo modo de deteção na Lupa para ajudar os utilizadores cegos ou com baixa visão, que foi concebido para ajudar os utilizadores a interagir com objetos físicos com numerosas etiquetas de texto. Por exemplo, a Apple diz que um utilizador pode apontar a câmara do seu dispositivo para uma etiqueta, ou para um teclado de um eletrodoméstico que o iPhone ou iPad lerá em voz alta à medida que o utilizador move o dedo por cada número, ou definição no aparelho.

Esta funcionalidade tira proveito da alta definição da câmara e recorre ao scanner LiDAR.

A Apple destacou uma série de outras funcionalidades que também vão chegar ao Mac, incluindo uma forma de os utilizadores surdos ou com dificuldades auditivas emparelharem os dispositivos auditivos Made for iPhone a funcionar com um Mac. A empresa também está a adicionar uma forma mais fácil de ajustar o tamanho do texto no Finder, Mensagens, Mail, Calendário e Notas no Mac.

Os utilizadores poderão ainda pausar as imagens GIF no Safari e nas Mensagens, personalizar a velocidade a que a Siri fala com eles e utilizar o Controlo por voz para obter sugestões fonéticas ao editar texto. Tudo isto se baseia nas funcionalidades de acessibilidade existentes da Apple para o Mac e iPhone, que incluem legendas em direto, um leitor de ecrã VoiceOver, deteção de portas e muito mais.

Fonte: Pplware.