Apple aplica medidas no combate à pornografia infantil

A Apple deixou 3 medidas e vamos explicar com mais detalhe como vão funcionar. Sobretudo, vamos entender como funciona a deteção de imagens de menores nas fotos do iCloud e as medidas de segurança da app Mensagens (iMessage) contra fotos explícitas.

As tecnologias visam a privacidade dos utilizadores, mas, sobretudo, a proteção dos menores.

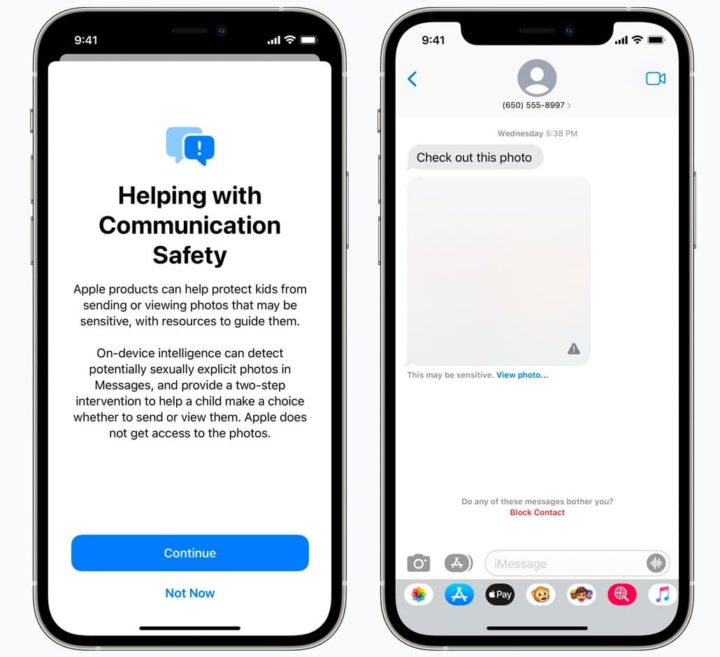

1 - Segurança na comunicação de Mensagens

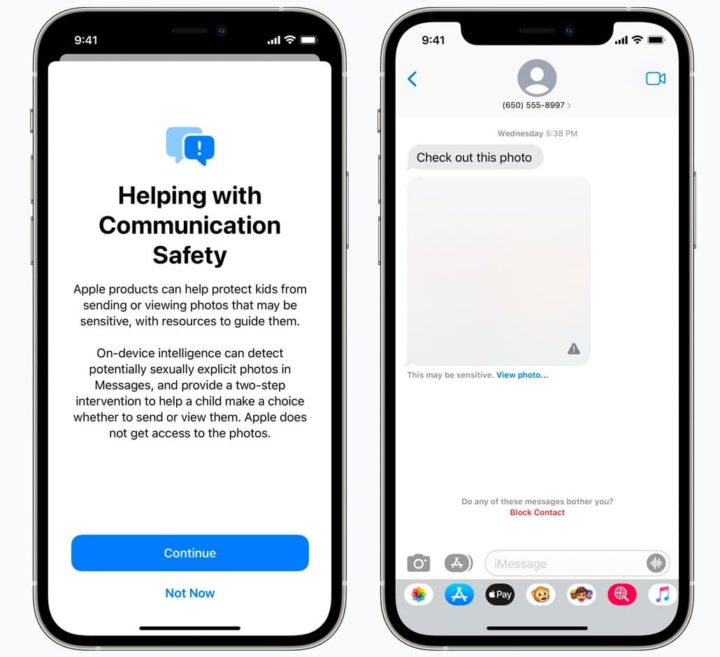

Conforme refere a Apple no seu site, o novo sistema de segurança de comunicações iMessage detetará e bloqueará imagens explícitas recebidas em conversas de crianças menores de 13 anos.

Esta é uma configuração opcional que os pais podem ajustar se desejarem e cuidará de ocultar as imagens inadequadas das conversas.

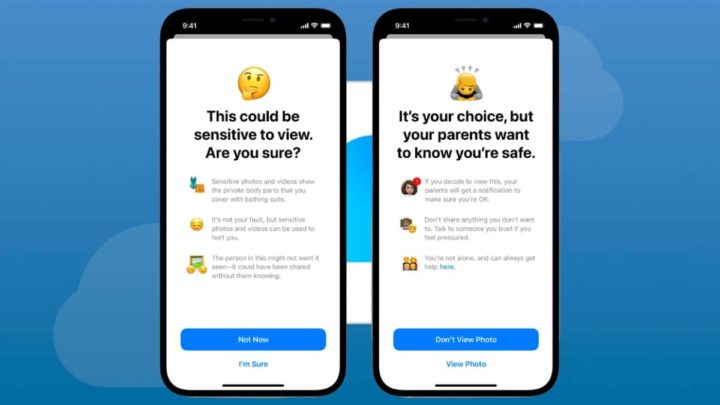

No entanto, a criança terá a opção de ver a imagem. O sistema atua ocultando a imagem e se esta for clicada a criança recebe uma mensagem a alertar que tal imagem pode ser sensível e explica a situação em três pontos:

- que as fotos sensíveis mostram partes do corpo que estão cobertas por fato de banho/roupa interior;

- que essas imagens podem ser usadas para prejudicar a sensibilidade;

- que a pessoa que aparece neles pode não querer ser vista.

Após esta explicação, o sistema permite à criança clicar nas opções "Agora não" ou "Tenho certeza".

Ao clicar na segunda opção, o sistema avisa que os pais "querem ter a certeza de que está bem", pelo que receberão uma notificação.

Também alerta a criança para não partilhar nada que não queira mesmo partilhar e para falar com alguém em quem confie se se sentir pressionada, e finalmente, oferece ajuda, afirmando que não está sozinha em certas situações. Depois oferece "Não ver a foto" ou "Ver a foto".

Conforme referimos, este sistema está concebido apenas para crianças menores de 13 anos, desde que os seus pais o considerem apropriado para o ativar.

A forma como a informação é comunicada, embora na língua das crianças, é muito clara e revela uma operação muito simples: se uma imagem explícita for detetada, é bloqueada, é dada a opção de escolher e os pais são avisados se for vista.

Este sistema funciona graças à aprendizagem automática no próprio dispositivo que analisa as imagens recebidas e também enviadas através do iMessage para apresentar avisos apropriados. Uma vez que todo o processamento ocorre localmente no dispositivo, ninguém, nem mesmo a Apple, tem acesso às mensagens, mantendo a segurança da app Mensagens em que confiamos.

2 - Deteção de imagens de menores no iCloud

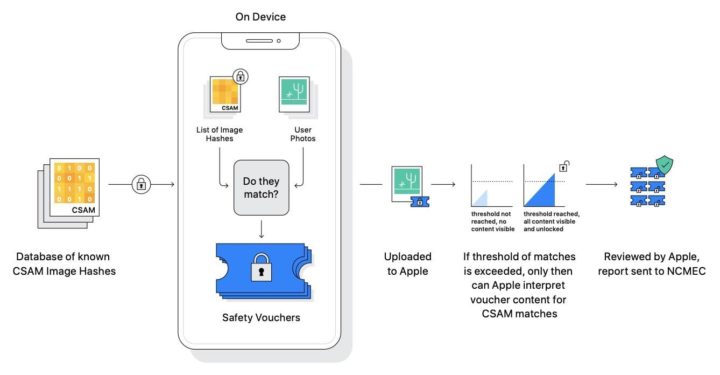

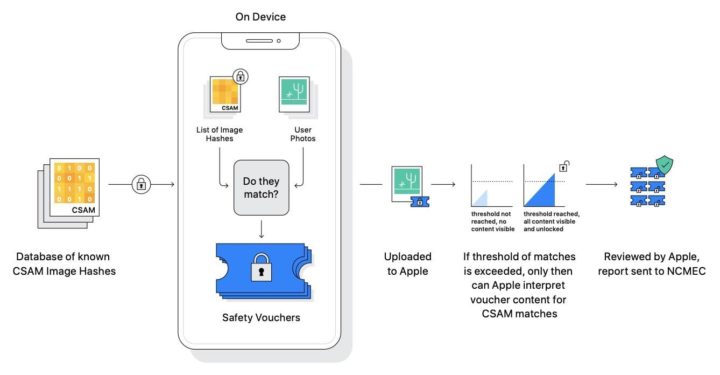

A outra medida que a Apple irá implementar é a deteção de imagens de menores de idade em bibliotecas de fotografia no iCloud. Um sistema que, mantendo a privacidade de todos os utilizadores, permitirá informar os organismos competentes caso sejam detetadas imagens que violem a lei. Como, por exemplo, pornografia infantil, entre outros abusos a crianças.

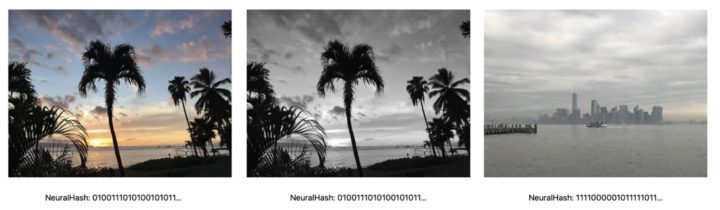

Em vez de monitorizar as imagens na cloud, com a consequente deterioração da privacidade, a Apple propõe um sistema que compara imagens de dispositivos com uma base de dados local. Esta base de dados é armazenada de forma segura no dispositivo e contém versões em hash das imagens relatadas pelas agências responsáveis, de modo a que o seu conteúdo seja completamente ilegível.

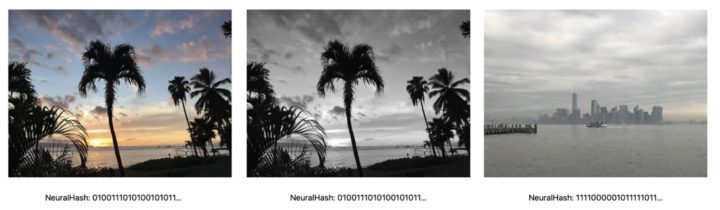

Estes hashes são concebidos de tal forma que não só representam a imagem original, mas também permitem variações da imagem original, tais como transformar a imagem em preto e branco ou cortar partes da mesma. Desta forma, versões da mesma imagem podem ser detetadas.

O sistema funciona de tal forma bem que antes de uma imagem ser carregada no iCloud Fotografias o dispositivo gera um hash da imagem e compara-a localmente com hashes de imagem relatados. O resultado desta verificação é ilegível a partir do dispositivo, em vez de ser aí analisado, o sistema envia um vouchers encriptado que é carregado para iCloud Fotografias junto com a imagem.

Então, é aqui que entra em jogo outra tecnologia, chamada threshold shared secretcy. Simplificando, a chave para decifrar o conteúdo dos vouchers cifrados é dividida em X fragmentos. Quando existem vouchers suficientes numa conta, a Apple recebe todos os pedaços da chave completa e pode decifrar o conteúdo destes vouchers, com as imagens que foram carregadas, revendo-as manualmente.

O limiar do voucher é estabelecido de forma a garantir que existe apenas uma hipótese em mil milhões por ano de marcar incorretamente determinado conteúdo.

Uma vez ultrapassado o limiar do voucher, a Apple recebe um relatório que pode decifrar e verificar manualmente. Se for confirmado que as imagens carregadas correspondem às da base de dados, a Apple suspende a conta e informa as autoridades. No entanto, oferece um sistema de recurso para restabelecer a conta se o utilizador considerar que foi cometido um erro.

Este mecanismo, que funcionará enquanto o dispositivo tiver o iCloud Fotografias ativado, foi concebido para proteger totalmente a nossa privacidade e, ao mesmo tempo, permitir-nos detetar imagens ilegais no sistema.

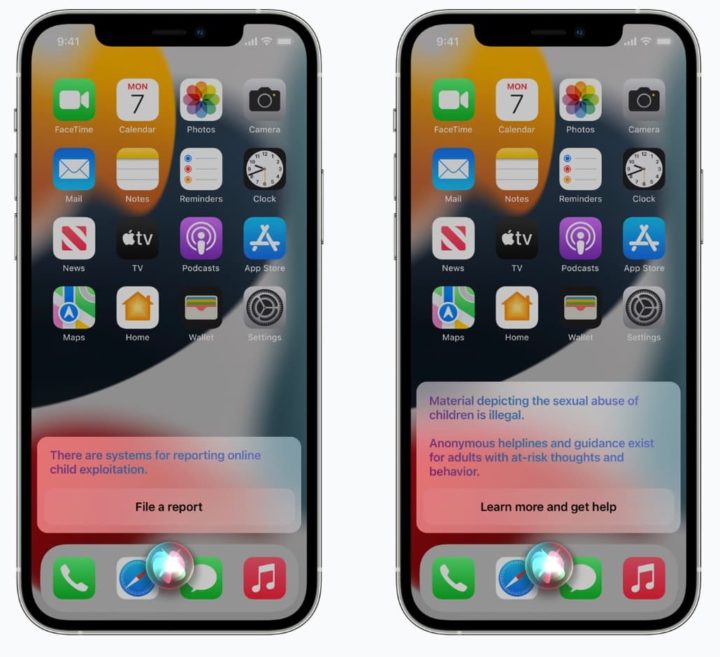

3 - Expandir a orientação na Siri e na Pesquisa

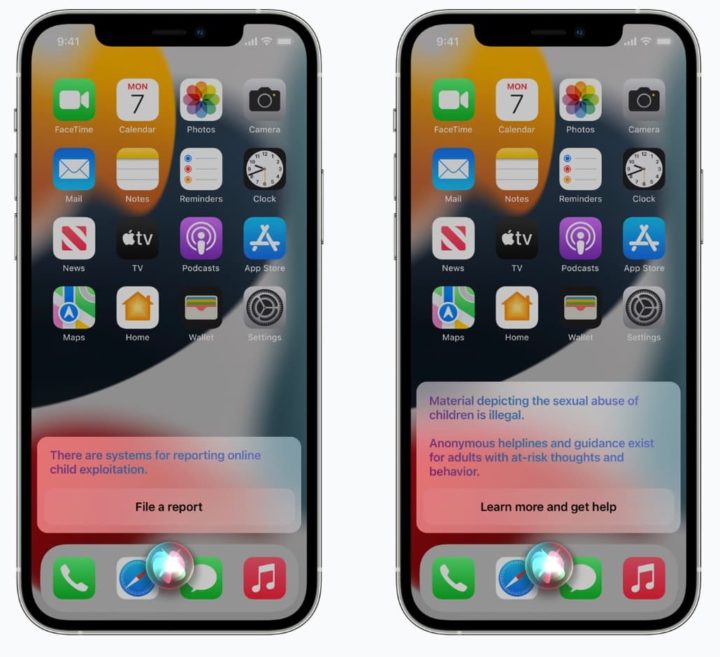

Por último, mas não menos importante, a Apple também está a expandir a orientação na Siri e na Pesquisa, fornecendo recursos adicionais para ajudar crianças e pais a se manterem seguros online e obter ajuda em situações inseguras.

Por exemplo, os utilizadores que perguntam à Siri como podem relatar Material de Abuso Sexual Infantil (CSAM) ou exploração infantil serão direcionados a recursos sobre onde e como registar uma denúncia.

A Siri e a Pesquisa também estão a ser atualizadas para intervir quando os utilizadores realizam pesquisas para consultas relacionadas ao CSAM. Estas intervenções irão explicar aos utilizadores que o interesse neste tópico é prejudicial e problemático, fornecendo recursos de parceiros para obter ajuda sobre este assunto.

Estas atualizações para a Siri e Pesquisa serão lançadas no final deste ano numa atualização para iOS 15, iPadOS 15, watchOS 8 e macOS Monterey.

Em resumo, estas novas ferramentas nos mais recentes sistemas operativos da Apple visam combater a pornografia infantil e outros atos abusivos perpetrados às crianças.

Fonte: Pplware.