O CSAM, a verificação de conteúdo de pornografia infantil da Apple, tem sido recebido com algumas questões mais sensíveis. Por norma associados à privacidade, estes pontos podem ter agora levado a que a Apple tenha mudado a sua posição.

A gigante de Cupertino tomou uma decisão importante e resolveu abandonar a verificação de conteúdo de pornografia infantil no iCloud. Com esta mudança, o CSAM está cada vez mais fora de serviço.

O fim do CSAM no iCloud

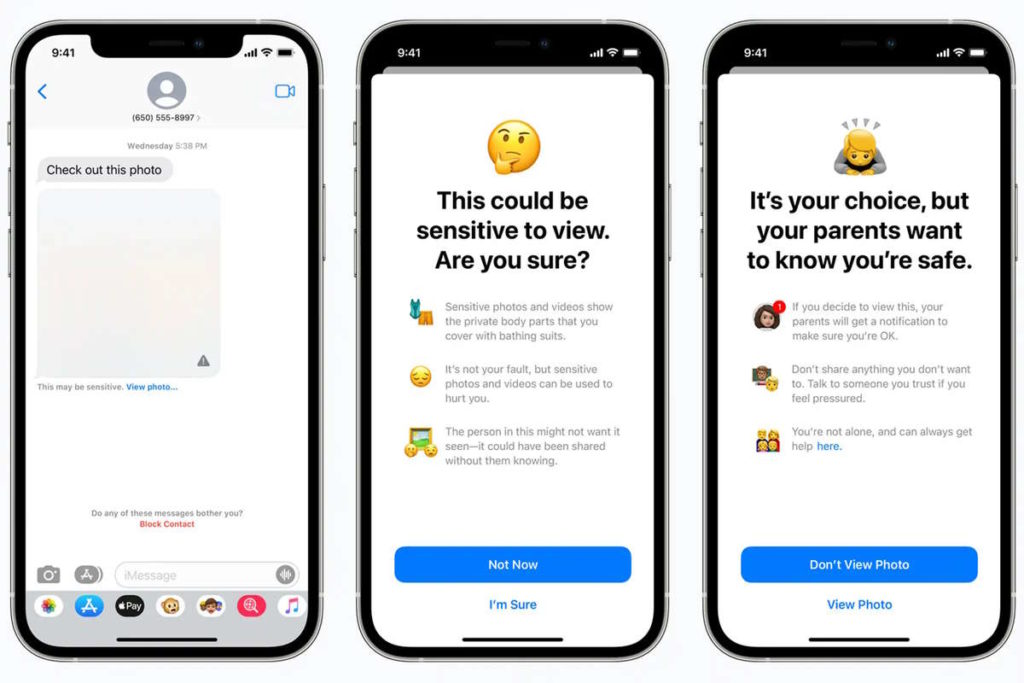

Em agosto de 2021, a Apple focou-se em apresentar novidades que pretendiam proteger os utilizadores mais novos. Entre estas estava o CSAM, que oferece a verificação de conteúdo de pornografia infantil no iCloud.

Agora, e durante a apresentação de mais uma novidade, a marca de Cupertino veio revelar que esta medida ia ser cancelada. Foca-se em questões de privacidade e na vontade de manter as imagens dos utilizadores longe de olhares alheios.

Após uma extensa consulta com especialistas para recolher feedback sobre as iniciativas de proteção infantil que propusemos no ano passado, estamos a aprofundar o nosso investimento no recurso de segurança de comunicação que disponibilizamos pela primeira vez em dezembro de 2021. Decidimos não avançar ainda com a nossa ferramenta para deteção de CSAM proposta anteriormente para o iCloud Photos. As crianças podem ser protegidas sem que as empresas vasculhem os dados pessoais, e continuaremos a trabalhar com governos, defensores de criança e outras empresas para ajudar a proteger os jovens, preservar o seu direito à privacidade e tornar a Internet um lugar mais seguro para as crianças e para todos nós

Verificar conteúdo de pornografia infantil

A Apple revelou inicialmente que a deteção de CSAM seria implementada numa atualização do iOS 15 e iPadOS 15 até o final de 2021. Acebou mais tarde por adiar este recurso com base no "feedback de clientes, grupos de defesa, pesquisadores e outros". Agora, depois de um ano de silêncio, a empresa abandonou completamente os planos de deteção de CSAM.

Na altura, a Apple foi criticada por indivíduos e organizações, incluindo a Electronic Frontier Foundation (EFF). alguns argumentaram que isto iria criar uma backdoor nos dispositivos, para que governos agências poderem vigiar os utilizadores. Outra preocupação eram os falsos positivos, incluindo a possibilidade de alguém adicionar imagens CSAM a outras contas do iCloud.

Mais novidades da Apple

Para além desta medida anunciada, a Apple revelou novidades no seu serviço cloud para proteger ainda mais os dados dos utilizadores. Falamos da Proteção Avançada de Dados, um recurso opcional que aplica criptografia de ponta a ponta a mais dados do iCloud.

Com esta novidade, o sistema que a Apple tinha projetado para fazer a verificação de conteúdo de pornografia infantil no iCloud está parado. A empresa indicou que não irá avançar agora, abrindo a porta para que no futuro ainda possa reverter esta decisão.

Fonte: Pplware.